Bases de données vectorielles : le cerveau caché de l’IA moderne

Derrière chaque ChatGPT, chaque moteur de recherche intelligent, et chaque système de recommandation se cache une technologie fondamentale mais méconnue : les bases de données vectorielles. Si vous vous demandez comment l’IA “comprend” le sens des mots et trouve des informations pertinentes parmi des millions de documents, vous êtes au bon endroit.

🧠 Qu’est-ce qu’un embedding ? La magie des nombres

L’idée révolutionnaire

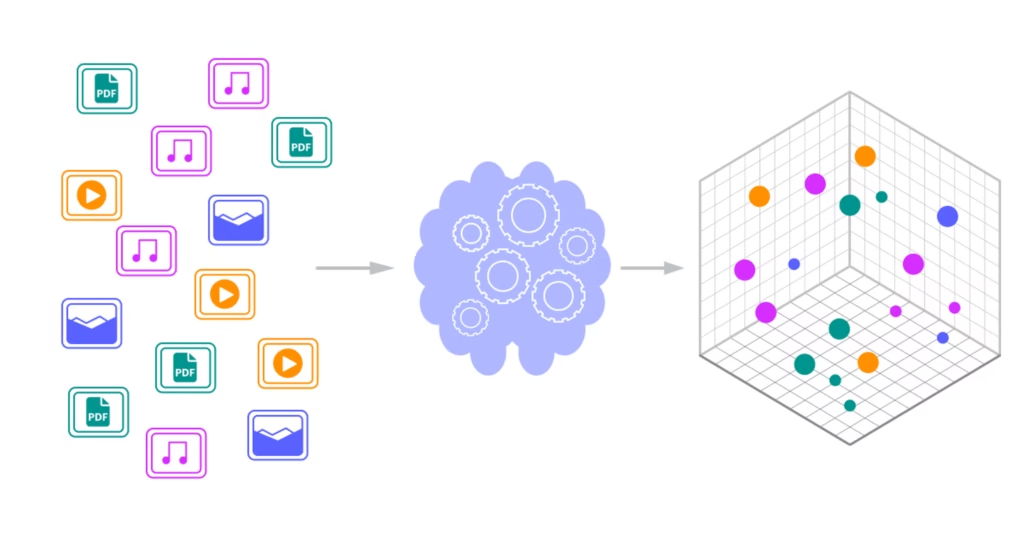

Un embedding, c’est la transformation d’informations complexes (texte, images, sons) en listes de nombres que les ordinateurs peuvent comprendre et comparer. C’est comme donner des “coordonnées GPS” à chaque concept dans un espace mathématique.

Exemple concret :

Phrase : "Le chat mange du poisson"

Embedding : [0.2, -0.8, 1.3, 0.7, -0.4, ..., 0.9]

↑

(1536 nombres pour OpenAI) Pourquoi c’est révolutionnaire ?

Les mots similaires ont des embeddings similaires :

- “Chat” et “Félin” → Vecteurs très proches

- “Chat” et “Voiture” → Vecteurs très éloignés

Cette “proximité mathématique” permet à l’IA de comprendre le sens, pas juste la forme des mots.

🔬 Comment sont créés les embeddings ?

1. Entraînement sur des corpus massifs

Les modèles d’embedding (Word2Vec, BERT, OpenAI) analysent des milliards de textes pour apprendre les relations entre les mots.

Le processus :

Milliards de textes → Modèle neural → Patterns sémantiques 2. Capture des relations complexes

Les embeddings capturent des relations subtiles :

- Analogies : “Roi” – “Homme” + “Femme” ≈ “Reine”

- Synonymes : “Grand” ≈ “Énorme” ≈ “Immense”

- Contexte : “Banque” (finance) vs “Banque” (rivière)

3. Dimension et richesse

Plus l’embedding a de dimensions, plus il peut capturer de nuances :

- Word2Vec : 300 dimensions

- OpenAI Ada : 1536 dimensions

- Google Vertex : 768-1024 dimensions

🏗️ Architecture d’une base de données vectorielle

Composants essentiels :

┌─────────────────────────────────────┐

│ Application Layer │

│ (Recherche, Recommandations, RAG) │

└─────────────────┬───────────────────┘

│

┌─────────────────▼───────────────────┐

│ Vector Database │

│ │

│ ┌─────────────┐ ┌──────────────┐ │

│ │ Vectors │ │ Metadata │ │

│ │ [1.2, -0.8, │ │ {id, title, │ │

│ │ 0.3, ...] │ │ timestamp} │ │

│ └─────────────┘ └──────────────┘ │

│ │

│ ┌─────────────────────────────────┐ │

│ │ Index Algorithms │ │

│ │ (HNSW, IVF, ANNOY...) │ │

│ └─────────────────────────────────┘ │

└─────────────────────────────────────┘ Algorithmes d’indexation

HNSW (Hierarchical Navigable Small World)

- Ultra-rapide pour la recherche

- Bon compromis vitesse/précision

- Utilisé par Weaviate, Qdrant

IVF (Inverted File Index)

- Partitionne l’espace vectoriel

- Efficace pour très grandes bases

- Utilisé par Faiss, Milvus

ANNOY (Approximate Nearest Neighbors)

- Optimisé pour la mémoire

- Read-only après construction

- Utilisé par Spotify

💡 Cas d’usage concrets avec l’IA

1. RAG (Retrieval-Augmented Generation)

Le problème : Les LLM ne connaissent que leurs données d’entraînement La solution : Enrichir avec des connaissances externes via vectorisation

Flow RAG :

Question utilisateur

↓

Vectorisation de la question

↓

Recherche similarité dans base vectorielle

↓

Récupération documents pertinents

↓

Injection dans prompt LLM

↓

Génération réponse enrichie Exemple pratique :

Question : "Quelle est notre politique de télétravail ?"

1. Vectorisation : [0.3, -0.7, 1.1, ...]

2. Recherche : Trouve documents RH similaires

3. Context : "Selon le règlement interne page 15..."

4. LLM génère : "Votre entreprise autorise le télétravail 2 jours/semaine..." 2. Moteur de recherche sémantique

Au lieu de chercher des mots-clés exacts, on cherche par sens :

Recherche traditionnelle :

Query: "voiture rouge"

Results: Documents contenant exactement "voiture" ET "rouge" Recherche vectorielle :

Query: "véhicule écarlate"

Results: Documents sur voitures rouges (même sans ces mots exacts) 3. Système de recommandation intelligent

Netflix/Spotify Approach:

User preferences → Embedding

Content features → Embedding

Similarité → Recommandations personnalisées 4. Classification automatique

Email entrant → Embedding

Comparaison avec embeddings de catégories

Attribution automatique (Spam/Important/Promo) 🛠️ Technologies et outils populaires

Bases de données vectorielles spécialisées

🥇 Pinecone (Leader du marché)

- Points forts : Fully managed, scaling automatique, très performant

- Pricing : $70/mois pour 5M vecteurs (1536 dim)

- Use case : Production enterprise, pas de gestion infrastructure

🥈 Weaviate (Open source mature)

- Points forts : Open source, modules pré-intégrés, GraphQL

- Pricing : Gratuit self-hosted, cloud à partir de $25/mois

- Use case : Contrôle total, intégrations riches

🥉 Qdrant (Performance focus)

- Points forts : Ultra-rapide, écrit en Rust, API simple

- Pricing : Gratuit self-hosted, cloud $0.40/GB/mois

- Use case : Applications haute performance

Autres options :

- ChromaDB → Simple, parfait pour prototypage

- Milvus → Très scalable, complexe à setup

- pgvector → Extension PostgreSQL, familiar pour devs SQL

Services d’embedding

Provider Modèle Dimensions Prix/1M tokens OpenAI text-embedding-3-large 3072 $0.13 OpenAI text-embedding-3-small 1536 $0.02 Cohere embed-english-v3.0 1024 $0.10 Google textembedding-gecko 768 $0.025 Voyage voyage-large-2 1536 $0.12

📊 Métriques de performance à surveiller

Qualité de recherche

- Recall@K : Proportion de documents pertinents trouvés dans les K premiers résultats

- Precision@K : Proportion de résultats pertinents dans les K premiers

- MRR (Mean Reciprocal Rank) : Position moyenne du premier résultat pertinent

Performance technique

- Latency P95 : Temps de réponse pour 95% des requêtes

- QPS (Queries Per Second) : Débit supporté

- Index size : Taille en mémoire/disque

- Accuracy vs Speed tradeoff : Compromis précision/vitesse

Coûts opérationnels

- Embedding cost : Prix de la vectorisation

- Storage cost : Coût de stockage des vecteurs

- Compute cost : CPU/GPU pour les recherches

⚡ Optimisations avancées

1. Chunking Strategy

# Mauvais : chunks trop petits ou trop grands

chunk_size = 100 # Perd le contexte

chunk_size = 5000 # Noie l'information

# Bon : équilibre optimal

chunk_size = 1000

chunk_overlap = 200 # Préserve la continuité 2. Embedding fine-tuning

Pour des domaines spécialisés (médical, juridique, technique) :

# Approche : Fine-tune sur corpus spécialisé

base_model = "text-embedding-3-small"

specialized_model = fine_tune_on_domain(base_model, domain_corpus) 3. Hybrid Search

Combine recherche vectorielle + keyword search :

# Vector search pour la sémantique

vector_results = vector_search(query, top_k=20)

# Keyword search pour la précision

keyword_results = keyword_search(query, top_k=20)

# Fusion des scores

final_results = rerank(vector_results, keyword_results) 4. Query expansion

def expand_query(original_query):

# Génère des variantes de la question

expanded = llm.generate(f"Paraphrase cette question de 3 façons différentes: {original_query}")

# Recherche sur toutes les variantes

all_results = []

for variant in expanded:

all_results.extend(vector_search(variant))

return deduplicate_and_rank(all_results) 🚨 Challenges et limitations

Problèmes techniques

Cold start problem : Performance dégradée au démarrage Curse of dimensionality : Performance qui baisse avec trop de dimensions Update complexity : Difficile de modifier des vecteurs existants

Challenges business

Coûts d’embedding : Peut exploser sur gros volumes Latency requirements : Temps de réponse vs qualité Data privacy : Embeddings peuvent révéler des informations sensibles

Solutions émergentes

- Quantization : Réduire la taille des vecteurs (8-bit au lieu de 32-bit)

- Approximate search : Sacrifier un peu de précision pour la vitesse

- Caching intelligent : Mémoriser les requêtes fréquentes

- Edge deployment : Modèles d’embedding locaux sur device

🔮 Tendances et évolution

Ce qui arrive en 2024-2025

Multimodal embeddings

- Vecteurs unifiés pour texte + image + audio

- Recherche cross-modale (“trouve moi des images qui correspondent à ce texte”)

Contextual embeddings

- Embeddings qui s’adaptent au contexte utilisateur

- Personnalisation automatique des résultats

Smaller, better models

- Embeddings plus compacts mais plus performants

- Optimisation pour mobile et edge computing

Graph + Vector hybrid

- Combinaison graphs de connaissances + recherche vectorielle

- Navigation sémantique et relationnelle combinée

🎯 Guide de démarrage pratique

Phase 1 : Prototype (1 semaine)

- Choisir un use case simple (FAQ, documentation interne)

- Setup ChromaDB local (installation en 5 minutes)

- Utiliser OpenAI embeddings (API simple)

- Implémenter recherche basique (50 lignes de code)

Phase 2 : MVP (1 mois)

- Migration vers Pinecone/Weaviate (solution managée)

- Optimisation chunking strategy (tests A/B)

- Interface utilisateur (frontend simple)

- Métriques basiques (latence, précision)

Phase 3 : Production (3 mois)

- Monitoring avancé (observabilité complète)

- Scaling automatique (gestion de charge)

- Sécurité (authentification, rate limiting)

- Optimisation coûts (quantization, caching)

Budget type pour démarrer :

MVP (< 1M documents) :

- Pinecone Starter : $70/mois

- OpenAI Embeddings : $50/mois

- Hosting API : $50/mois

Total : ~$170/mois

Scale (10M+ documents) :

- Vector DB : $500-2000/mois

- Embeddings : $200-1000/mois

- Infrastructure : $300-1000/mois

Total : $1000-4000/mois 🏆 Success stories

Netflix

- Challenge : Recommander parmi 15,000+ titres

- Solution : Embeddings des préférences utilisateur + contenu

- Résultat : 80% du contenu regardé vient des recommandations

Notion

- Challenge : Recherche dans millions de documents utilisateur

- Solution : Vector search sémantique

- Résultat : Recherche 10x plus pertinente que keyword search

OpenAI

- Challenge : ChatGPT ne connaît pas l’info récente

- Solution : RAG avec web browsing + vector retrieval

- Résultat : Réponses contextualisées et à jour

🚀 Conclusion : l’infrastructure invisible de l’IA

Les bases de données vectorielles sont l’infrastructure invisible qui permet à l’IA de “comprendre” notre monde. Elles transforment l’information brute en connaissance searchable, permettant aux machines de naviguer dans l’océan de données comme nous naviguons dans nos souvenirs.

Key takeaways :

- Embeddings = GPS des concepts dans l’espace mathématique

- Vector DB = cerveau qui stocke et rappelle la connaissance

- RAG = synergie entre recherche vectorielle et génération

- Performance = compromis entre vitesse, précision et coût

- Futur = multimodal et contextuel

L’IA conversationnelle n’est que la partie émergée de l’iceberg. En dessous, les bases de données vectorielles font le gros du travail pour donner du sens à nos données.

Question stratégique : Dans votre organisation, quelles données gagneraient à être “vectorisées” pour libérer leur potentiel avec l’IA ?